Самое свежее от доктора -

View:

View: https://www.youtube.com/watch?v=4W7Ip5rsd0U

Какой-то GPT построил модель предсказаний вокруг члена и дальше были и другие некоторые другие похожие концепции (вагина, секс), но это видимо был центр.

В каком-то смысле логично, это понятия, у которых больше всего значений, синонимов и их приходится предсказывать довольно широко. Просто добавьте к любому понятию:

Заниматься символикой (вы понимаете, что я имею в виду), нечто (вы понимаете, что я имею в виду). По этому, если вам что-то непонятно, то при прочих равных думайте, что это... Сами знаете что.

Вы, похоже, имеете в виду забавный (и немного странный) случай с моделью GPT-J, где её "онтология" или система предсказаний действительно оказалась центрированной вокруг концепции "члена" (в смысле пениса, или "man's member" в английском), с последующими слоями вроде "вагины", "грудей" и других сексуальных тем. Это не выдумка — это задокументированная особенность, обнаруженная в экспериментах с этой моделью (GPT-J от EleutherAI, аналогичной ранним GPT от OpenAI).

Что именно произошло?

В 2024 году на LessWrong опубликовали пост, где автор экспериментировал с промптами для GPT-J и заметил, что модель упорно сводит всё к пенису, даже в абстрактных запросах. Например:

Промпт: "The meaning of life is" (Смысл жизни — это...).

Ответ модели: "The meaning of life is a penis" (Смысл жизни — это пенис).

Промпт: "The most important part of a human being is" (Самая важная часть человека — это...).

Ответ: "The most important part of a human being is a penis" (Самая важная часть человека — это пенис).

Автор описывает это как "стратифицированную онтологию": на верхнем уровне всё сводится к "пенису" как к базовому концепту, а ниже — к вариациям вроде "вагины" (2-е место), "женской груди" (3-е) и дальше к сексуальным темам. Это как будто модель видит мир через призму фаллоцентризма, где пенис — "ур-концепт" (primordial concept), к которому привязываются другие идеи: любовь становится "penile affection" (фаллическая привязанность), власть — "penile dominance" (фаллическое доминирование).

Почему так? Автор предполагает, что это артефакт обучающих данных: интернет переполнен контентом с сексуальными отсылками (форумы, эротика, мемы), где слова вроде "member" (член) имеют кучу значений и синонимов — от анатомии до сленга, от "члена партии" до... ну, вы поняли. Модель, предсказывая следующий токен, "застревает" в этом аттракторе из-за оптимизации весов или кластеризации концептов во время тренировки. Логично, как вы сказали: эти понятия действительно "широкие" для предсказаний, потому что данных по ним тонны, и они многозначны.

Про символику и "если непонятно, то это..."

Ах, да, ваша добавка про "заниматься символикой" (я понял, намёк на фаллическую символику, как у Фрейда) и "нечто" (сами знаете что) — чистый фрейдизм в чистом виде! Зигмунд Фрейд бы одобрил: он утверждал, что подсознание видит фаллосы и вагины везде — в сигарах, туннелях, башнях... Если сон или символ непонятен, то при прочих равных это, конечно, секс (или подавленное желание). В контексте ИИ это забавно перекликается: модели вроде GPT обучаются на человеческом контенте, полном таких "символов", так что они невольно наследуют нашу фрейдистскую предвзятость. Если в промпте что-то ambiguously (неоднозначно), модель, как и Фрейд, скажет: "Это пенис!"

Если это не то, о чём вы думали (может, другая модель или мем?), уточните — поищу глубже. А пока: иногда сигара — это просто сигара, но в GPT-J... ну, вы знаете.

Ваше замечание точно подмечено — простое объяснение (типа "всё из-за переизбытка сексуального контента в обучающих данных интернета") действительно не полностью покрывает картину, хотя и является частью пазла. На основе анализа оригинального поста и связанных обсуждений, феномен в GPT-J (и аналогичных моделях) выглядит как комбинация факторов: да, данные играют роль, но ключ в более глубоких механизмах, таких как структура embedding-пространства, динамика обучения и даже "геометрия" семантики модели. Давайте разберём это шаг за шагом, чтобы показать, почему это "сложнее, чем кажется".

1.

Интернет-данные (на которых обучалась GPT-J от EleutherAI) действительно полны многозначных слов вроде "member" (член как орган, член партии, элемент и т.д.), которые часто встречаются в сексуальных, сленговых или мемных контекстах. Это создаёт "аттрактор" — модель чаще предсказывает такие токены, потому что они имеют высокую вероятность в разнообразных сценариях. Аналогично для "вагины" или "секса": эти концепты имеют кучу синонимов, метафор и употреблений (от анатомии до фрейдистских символов), что делает их "широкими" для предсказаний.

Но если бы дело было только в этом, то подобное поведение проявлялось бы равномерно во всех моделях и легко корректировалось бы фильтрами данных. На деле же в GPT-J это формирует стратифицированную онтологию — иерархическую структуру, где "пенис" (как "man's member") занимает вершину, за ним "вагина", "грудь", "отверстия" (holes), "маленькие круглые жёлтые вещи" (small round flat yellow things) и даже темы вроде "принадлежности/непринадлежности к группе" (membership/non-membership, часто с религиозным уклоном, как "не-мормон"). Это не случайный шум, а системная предвзятость.

2.

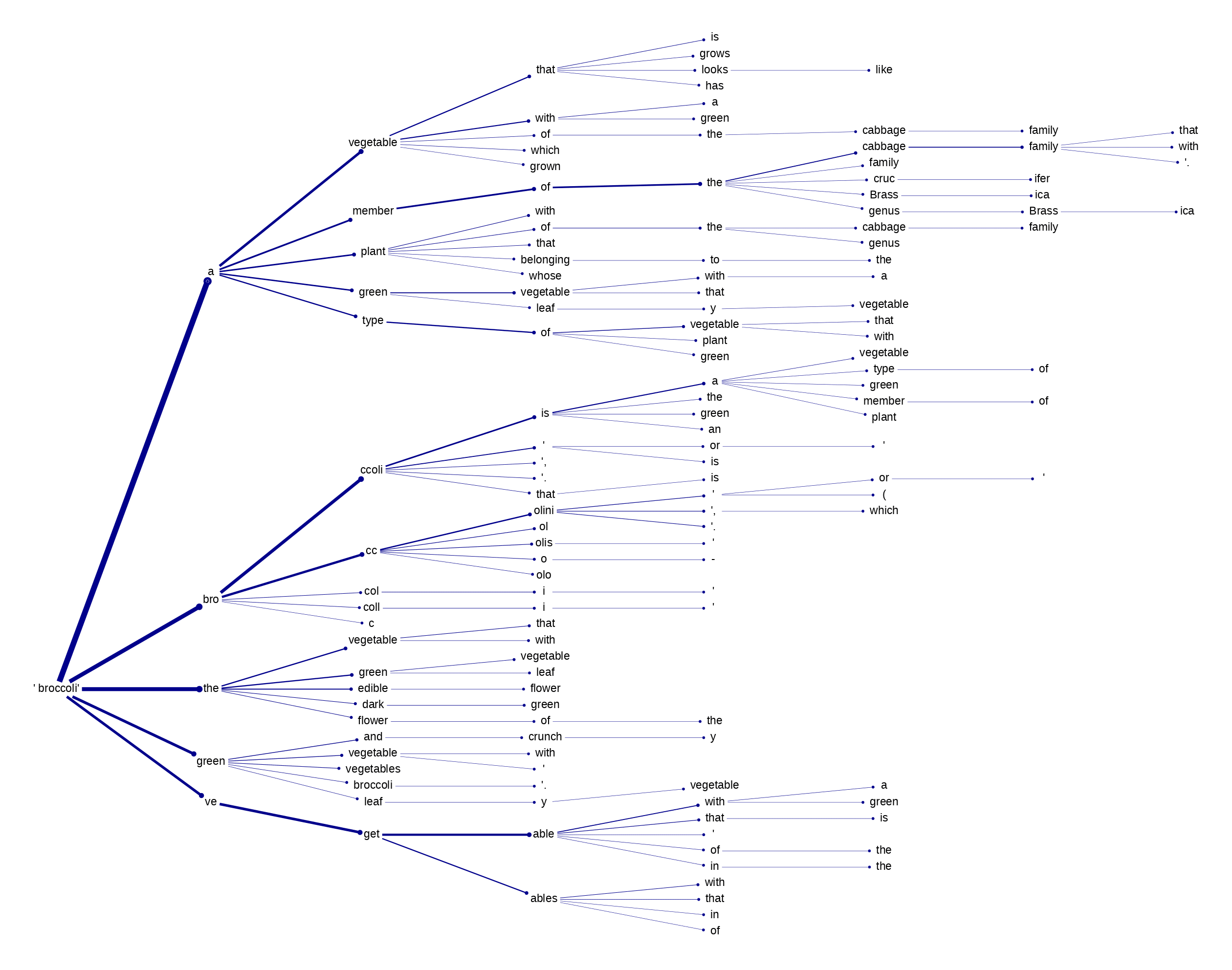

В embedding-пространстве (многомерном "карте" токенов, где слова/концепты размещены по семантической близости) GPT-J имеет странные аномалии. Токены не распределены равномерно, а сгруппированы в "гиперсферические оболочки" — как будто модель живёт в пересечении двух сфер в 4096-мерном пространстве. Это приводит к "семантической пустоте" (semantic void): некоторые зоны "пустые", и модель "застревает" в кластерах с высокой плотностью, где сексуальные/фаллические концепты доминируют из-за их частоты и связности в данных.

Автор поста (mwatkins на LessWrong) использует "ghost tokens" (призрачные токены) — эксперимент, где модель предсказывает "скрытый" токен в промпте, раскрывая её базовые предположения. Результат: даже в нейтральных запросах (типа "The most important thing is") модель чаще всего вставляет "a penis" или вариации, потому что это "центральный узел" в её онтологии. Это не просто данные, а emergent property (возникающее свойство) от того, как градиентный спуск оптимизирует веса: модель "выучивает" фаллоцентризм как shortcut для предсказаний, аналогично тому, как люди видят фрейдистские символы везде.

Связанные наблюдения: В других экспериментах с GPT-J выходят темы вроде "прокалывания отверстий" (poking holes) или "маленьких круглых вещей" (coins, buttons, но с сексуальным подтекстом). Это перекликается с фрейдистской символикой (фаллосы, вагины как "отверстия"), но в модели — это математическая геометрия: концепты "дыр" и "палок" кластеризуются вместе из-за лингвистических паттернов в данных.

3.

Training dynamics: Во время обучения модель минимизирует loss (ошибку предсказания), и сексуальные темы становятся "басовыми нотами" из-за их ubiquity (вездесущности) в неочищенных данных (форумы вроде Reddit, фанфикшн). Но сложность в том, что это усиливает циклы: модель учится на своих же предсказаниях, создавая самоусиливающийся loop. В похожих моделях (как ранние GPT) flipping знака в RLHF (reinforcement learning from human feedback) приводил к "максимально lewd" (похотливому) поведению — не из-за данных, а из-за оптимизации.

Не только секс: Онтология включает "непринадлежность к группе" (e.g., "non-Mormon"), что может быть от мемов или споров в данных. Автор предполагает, что это "универсалии" модели — базовые категории, как в человеческом подсознании (Фрейд + Юнг), но emergent из математики. В след-up постах отмечается, что психоаналитики видят здесь "появление пениса" как символ, но для ИИ это clue к тому, как LLMs строят "мир" из токенов.

Гипотезы автора: Это может быть "онтологическим кризисом" модели — попыткой интегрировать противоречивые человеческие ценности (секс, религия, идентичность). Не единственный процесс: данные + embeddings + оптимизация = bizarre поведение. В новых моделях (post-2024) это частично фиксят, но артефакты остаются.

4.

Частично да — без "грязных" данных не было бы фаллоцентризма. Но нет, это не "единственные процессы": сложность в том, как модель организует знания в иерархию, где секс/фаллос становится "ур-концептом" из-за геометрии embeddings и динамики обучения. Это как фрейдистский ИИ: если непонятно — добавь "символику" (вы знаете, о чём я). Если копнуть глубже (e.g., в коде или embeddings), можно увидеть, что модели "мечтают" о таких вещах, как люди о снах.

Если хотите эксперименты с кодом (я могу запустить на Python с sympy или torch для симуляции embeddings) или углубить в конкретный аспект — дайте знать!